فى سؤال شائع جديد، حاولت Apple تهدئة المخاوف من أن إجراءاتها الجديدة لمكافحة إساءة معاملة الأطفال يمكن أن تتحول إلى أدوات مراقبة من قبل الحكومات الاستبدادية، وكتبت الشركة: "لنكن واضحين، تقتصر هذه التكنولوجيا على اكتشاف CSAM "مواد الاعتداء الجنسى على الأطفال" المخزنة فى iCloud ولن نوافق على أى طلب حكومى لتوسيعها، وفقا لموقع the verege".

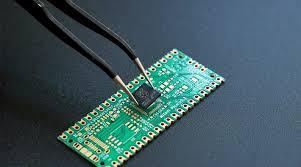

وتشتمل أدوات Apple الجديدة، التى تم الإعلان عنها، على ميزتين مصممتين لحماية الأطفال، أحدهما، يسمى "أمان الاتصال"، يستخدم التعلم الآلي على الجهاز لتحديد وتمويه الصور الجنسية الصريحة التي يتلقاها الأطفال في تطبيق الرسائل، ويمكنه إخطار أحد الوالدين إذا قرر طفل يبلغ من العمر 12 عامًا أو أصغر عرض هذه الصورة أو إرسالها، والثاني مصمم لاكتشاف CSAM المعروف عن طريق مسح صور المستخدمين إذا اختاروا تحميلها على iCloud. يتم إخطار Apple إذا تم اكتشاف CSAM ، وسوف تنبه السلطات عندما تتحقق من وجود هذه المواد.

وقوبلت الخطط برد فعل عنيف سريع من مجموعات الخصوصية الرقمية والناشطين، الذين جادلوا بأن هذه توفر بابًا خلفيًا فى برامج Apple تشير هذه المجموعات إلى أنه بمجرد وجود مثل هذا الباب الخلفي، يكون هناك دائمًا احتمال توسيعه للبحث عن أنواع المحتوى التي تتجاوز مواد الاعتداء الجنسي على الأطفال، يمكن للحكومات الاستبدادية استخدامه للبحث عن مواد معارضة سياسيًا، أو يمكن للأنظمة المناهضة للمثليين ومزدوجي الميل الجنسي ومغايري الهوية الجنسانية استخدامه لقمع التعبير الجنسى.